语音交互方法及其系统和对话设备.pdf

语音交互方法及其系统和对话设备.pdf

《语音交互方法及其系统和对话设备.pdf》由会员分享,可在线阅读,更多相关《语音交互方法及其系统和对话设备.pdf(16页完成版)》请在专利查询网上搜索。

1、(19)中华人民共和国国家知识产权局 (12)发明专利申请 (10)申请公布号 (43)申请公布日 (21)申请号 201911172944.6 (22)申请日 2019.11.26 (71)申请人 杭州博拉哲科技有限公司 地址 310000 浙江省杭州市滨江区长河街 道长河路475号S1幢6层620室 (72)发明人 周波王天宇陈涛李文俊 (74)专利代理机构 杭州裕阳联合专利代理有限 公司 33289 代理人 姚宇吉 (51)Int.Cl. G10L 15/06(2013.01) G10L 15/16(2006.01) G10L 15/18(2013.01) G10L 15/22(2006。

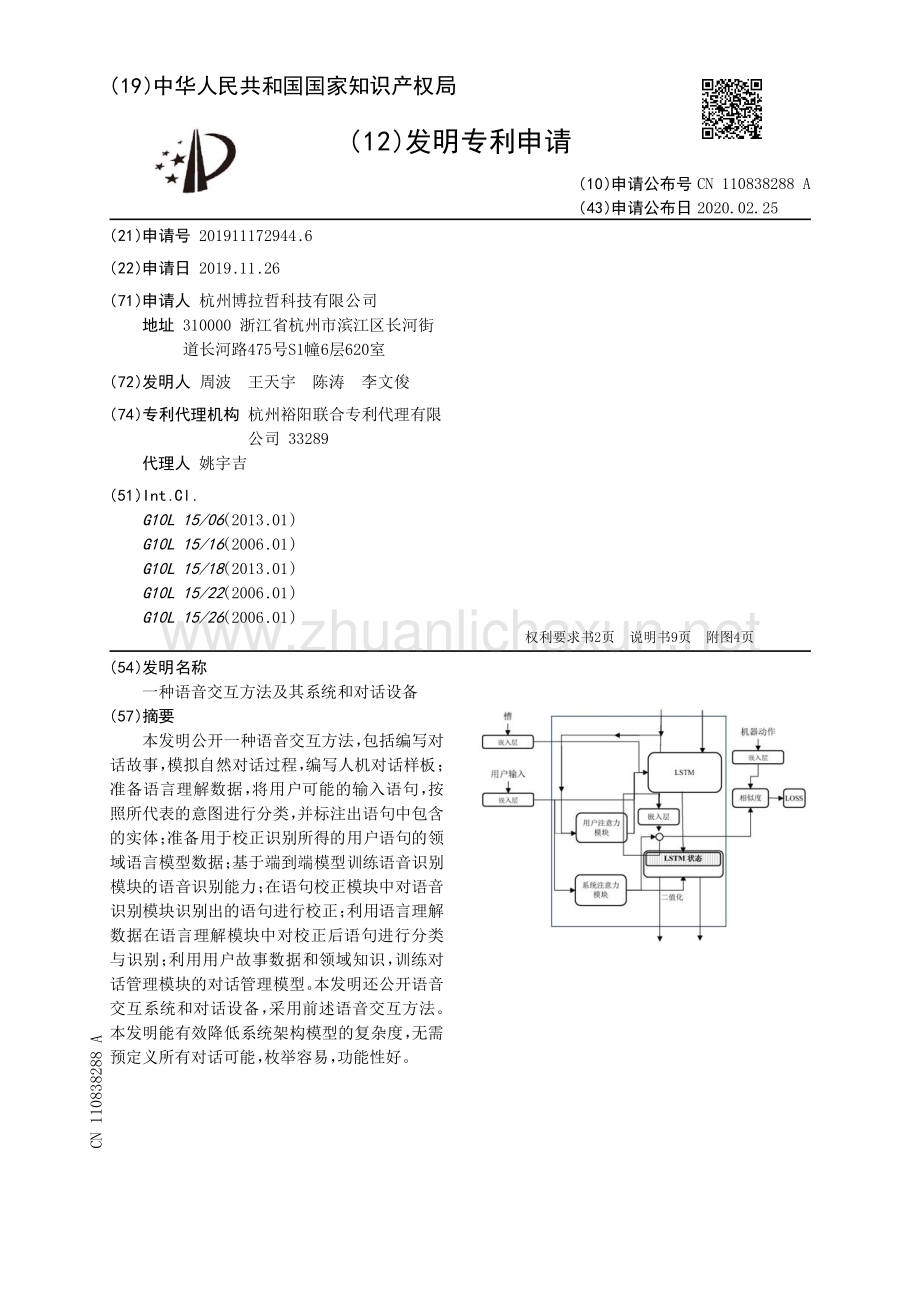

2、.01) G10L 15/26(2006.01) (54)发明名称 一种语音交互方法及其系统和对话设备 (57)摘要 本发明公开一种语音交互方法, 包括编写对 话故事, 模拟自然对话过程, 编写人机对话样板; 准备语言理解数据, 将用户可能的输入语句, 按 照所代表的意图进行分类, 并标注出语句中包含 的实体; 准备用于校正识别所得的用户语句的领 域语言模型数据; 基于端到端模型训练语音识别 模块的语音识别能力; 在语句校正模块中对语音 识别模块识别出的语句进行校正; 利用语言理解 数据在语言理解模块中对校正后语句进行分类 与识别; 利用用户故事数据和领域知识, 训练对 话管理模块的对话管理模。

3、型。 本发明还公开语音 交互系统和对话设备, 采用前述语音交互方法。 本发明能有效降低系统架构模型的复杂度, 无需 预定义所有对话可能, 枚举容易, 功能性好。 权利要求书2页 说明书9页 附图4页 CN 110838288 A 2020.02.25 CN 110838288 A 1.一种语音交互方法, 其特征在于, 包括以下步骤: 编写对话故事, 模拟自然的对话过程, 编写人机对话样板, 用于模型训练; 准备语言理解数据, 将用户可能的输入语句, 按照所代表的意图进行分类, 并标注出语 句中包含的实体; 准备用于校正识别所得的用户语句的领域语言模型数据; 基于端到端模型训练语音识别模块的语音。

4、识别能力; 利用所述领域语言模型数据在语句校正模块中对语音识别模块识别出的语句进行校 正; 利用所述语言理解数据在语言理解模块中对校正后语句进行分类与识别; 利用用户故事数据和领域知识, 训练对话管理模块的对话管理模型。 2.根据权利要求1所述的一种语音交互方法, 其特征在于, 所述对话管理模型采用基于 嵌入机制的深度学习模型, 并通过对所述基于嵌入机制的深度学习模型进行循环神经网络 计算而得到循环嵌入对话管理模型, 所述循环嵌入对话管理模型的建立步骤包括: 将用户输入、 机器动作和槽进行向量化, 形成能够用来训练深度学习模型的特征向量, 所述特征向量包括用户输入特征向量、 机器动作特征向量和。

5、槽特征向量; 将所述特征向量输入嵌入层来创建嵌入向量, 所述嵌入向量包括用户输入嵌入向量、 机器动作和槽嵌入向量; 将用户输入嵌入向量分别输入用户注意力模块和系统注意力模块, 得到用户输入的用 户注意力向量, 和用户输入的系统注意力向量; 将用户输入嵌入向量与用户输入的注意力向量相加, 并将槽嵌入向量连接到所述用户 输入嵌入向量与用户输入的注意力向量相加的计算结果的尾端, 最后所得的数据一起输入 LSTM单元; 将LSTM单元的输出通过嵌入层计算到当前时间步的嵌入向量, 并将所述当前时间步的 嵌入向量与用户输入的系统注意力向量相加而得到当前时间步的对话状态向量; 计算所述当前时间步的对话状态向。

6、量与目标机器动作嵌入向量的正确相似度。 3.根据权利要求2所述的一种语音交互方法, 其特征在于, 所述循环嵌入对话管理模型 的建立步骤还包括: 采用负采样的方法获得当前时间步的对话状态向量与错误的机器动作嵌入向量的错 误相似度, 将正确相似度与错误相似度均代入损失函数, 通过使所述损失函数最小化来提 高正确相似度, 降低错误相似度。 4.根据权利要求3所述的一种语音交互方法, 其特征在于, 在所述循环嵌入对话管理模型的建立步骤中, 所述用户注意力模块包括注意力机制、 神经图灵机与记忆模块, 所述系统注意力模块也包括注意力机制、 神经图灵机与记忆模块。 5.根据权利要求4所述的一种语音交互方法,。

7、 其特征在于, 所述注意力机制的计算采用 Bahdanau分数的插值; 所述神经图灵机用于将记忆模块中的值切断, 而只使用当前时间步 之前的时间步的信息。 6.根据权利要求5所述的一种语音交互方法, 其特征在于, 所述语句校正模块采用基于 transformer的encoder-decoder模型; 所述基于transformer的encoder-decoder模型的架 构建立步骤包括: 权利要求书 1/2 页 2 CN 110838288 A 2 利用word2vec对输入语句进行词嵌入训练, 从而得到样本的嵌入矩阵; 利用正弦和余弦函数进行位置编码; 将所述位置编码所得的样本集输入多头注意。

8、力模型; 将所述多头注意力模型的输出送入前馈神经网络; 所述多头注意力模型与所述前馈神经网络构成encoder, 将encoder输出的特征矩阵输 入decoder; 获得输入语句的对应文字。 7.根据权利要求6所述的一种语音交互方法, 其特征在于: 所述decoder包括两层堆叠的多头注意力模型和一层前馈神经网络; 第一层所述多头注意力模型采用输出标签作为输入; 第二层所述多头注意力模型采用所述encoder的输出作为输入; 第二层所述多头注意力模型的输出在经由前馈神经网络计算之后输入到softmax函 数, 所述softmax函数输出概率; 对所述softmax函数的输出概率通过贪心算法的。

9、计算, 选择最大概率; 对所述最大概率 进行词典查找获得获得输入语句的对应文字。 8.根据权利要求7所述的一种语音交互方法, 其特征在于: 所述语音识别模块基于DeepSpeech/wav2letter+/DFSMN的端到端模型训练语音识别 能力; 所述语言理解模块采用bert进行语句进行嵌入, 再利用DNN+softmax来对校正后语句 进行分类与识别。 9.一种语音交互系统, 采用权利要求1-8所述的语音交互方法, 其特征在于: 包括语音 识别模块、 语句校正模块、 语言理解模块以及对话管理模块; 所述语音识别模块基于wav2letter+框架, 采用全卷积神经网络; 所述语句校正模块采用。

10、基于transformer的encoder-decoder模型; 所述语言理解模块采用bert模型进行语句嵌入, 利用DNN+softmax进行分类与识别; 所述对话管理模块采用循环嵌入对话管理模型。 10.一种对话设备, 采用权利要求9所述的语音交互系统, 其特征在于: 包括接口、 处理 器以及存储器; 所述处理器利用各个接口和线路来连接整个对话设备硬件的各个部分, 并通过运行或 执行存储在存储器中的软件程序和/或模块, 以及调用存储在存储器中的数据, 来执行对话 设备硬件的各种功能和处理数据, 从而对对话设备硬件进行整体的控制。 所述存储器包括存储程序区和存储数据区; 所述存储程序区存储有。

11、存储操作系统、 驱 动程序模块、 语音识别模块、 语句校正模块、 语言理解模块和对话管理模块; 所述存储数据 区存储有所述对话设备硬件因使用所创建的数据; 所述存储器还包括用于提供所述处理器 对存储器访问的存储器控制器。 权利要求书 2/2 页 3 CN 110838288 A 3 一种语音交互方法及其系统和对话设备 技术领域 0001 本发明涉及人机交互领域, 尤其涉及一种语音交互方法及其系统和对话设备。 背景技术 0002 近几年来, 随着人工智能的飞速发展, 市场上出现了多种多样的语音对话机器人, 用于手机助手、 智能客服、 语音导航、 智能音箱等场景。 这些语音交互系统的核心模块一般 。

12、包括语音识别、 语音理解、 对话管理等模块。 0003 语音识别模块一般采用DNN-HMM模型或者深度学习模型, 通用的语音识别模型在 特定领域的对话中, 准确率会大打折扣, 从而导致后续语言理解模块难以有效工作。 语音理 解模块一般采用流水线式作业, 把工作流程分拆成几个部分, 用多个模型一次对数据进行 处理, 执行分词、 命名实体识别、 意图识别等任务, 模型复杂, 计算量大。 对话管理模块一般 会采用对话管理方法, 包括基于有限状态机的对话管理算法、 基于槽位填充的对话管理算 法和基于代理(Agent)的对话管理方法, 但是基于有限状态机的对话管理算法, 需要预定义 所有的对话可能, 枚。

13、举困难, 难以处理异常情况, 功能性较差; 基于槽位填充的对话管理算 法, 只能处理槽位填充问题; 基于Agent的对话管理方法开发复杂, 维护和可拓展性较差。 由 于上述的系统架构、 模型的复杂性, 导致多年以来实时语音交互系统发展进程缓慢。 发明内容 0004 本发明针对现有技术中的不足, 提供一种语音交互方法, 包括以下步骤: 编写对话 故事, 模拟自然的对话过程, 编写人机对话样板, 用于模型训练; 准备语言理解数据, 将用户 可能的输入语句, 按照所代表的意图进行分类, 并标注出语句中包含的实体; 准备用于校正 识别所得的用户语句的领域语言模型数据; 基于端到端模型训练语音识别模块的。

14、语音识别 能力; 利用所述领域语言模型数据在语句校正模块中对语音识别模块识别出的语句进行校 正; 利用所述语言理解数据在语言理解模块中对校正后语句进行分类与识别; 利用用户故 事数据和领域知识, 训练对话管理模块的对话管理模型。 0005 特别的, 所述对话管理模型采用基于嵌入机制的深度学习模型, 并通过对所述基 于嵌入机制的深度学习模型进行循环神经网络计算而得到循环嵌入对话管理模型, 所述循 环嵌入对话管理模型的建立步骤包括: 将用户输入、 机器动作和槽进行向量化, 形成能够用 来训练深度学习模型的特征向量, 所述特征向量包括用户输入特征向量、 机器动作特征向 量和槽特征向量; 将所述特征向。

15、量输入嵌入层来创建嵌入向量, 所述嵌入向量包括用户输 入嵌入向量、 机器动作和槽嵌入向量; 将用户输入嵌入向量分别输入用户注意力模块和系 统注意力模块, 得到用户输入的用户注意力向量, 和用户输入的系统注意力向量; 将用户输 入嵌入向量与用户输入的注意力向量相加, 并将槽嵌入向量连接到所述用户输入嵌入向量 与用户输入的注意力向量相加的计算结果的尾端, 最后所得的数据一起输入LSTM单元; 将 LSTM单元的输出通过嵌入层计算到当前时间步的嵌入向量, 并将所述当前时间步的嵌入向 量与用户输入的系统注意力向量相加而得到当前时间步的对话状态向量; 计算所述当前时 说明书 1/9 页 4 CN 110。

16、838288 A 4 间步的对话状态向量与目标机器动作嵌入向量的正确相似度。 0006 可选地, 所述循环嵌入对话管理模型的建立步骤还包括: 采用负采样的方法获得 当前时间步的对话状态向量与错误的机器动作嵌入向量的错误相似度, 将正确相似度与错 误相似度均代入损失函数, 通过使所述损失函数最小化来提高正确相似度, 降低错误相似 度。 0007 可选地, 在所述循环嵌入对话管理模型的建立步骤中, 所述用户注意力模块包括 注意力机制、 神经图灵机与记忆模块, 所述系统注意力模块也包括注意力机制、 神经图灵机 与记忆模块。 0008 可选地, 所述注意力机制的计算采用Bahdanau分数的插值; 所。

17、述神经图灵机用于 将记忆模块中的值切断, 而只使用当前时间步之前的时间步的信息。 0009 可选地, 所述语句校正模块采用基于transformer的encoder-decoder模型; 所述 基于transformer的encoder-decoder模型的架构建立步骤包括: 利用word2vec对输入语句 进行词嵌入训练, 从而得到样本的嵌入矩阵; 利用正弦和余弦函数进行位置编码; 将所述位 置编码所得的样本集输入多头注意力模型; 将所述多头注意力模型的输出送入前馈神经网 络; 所述多头注意力模型与所述前馈神经网络构成encoder, 将encoder输出的特征矩阵输 入decoder; 获。

18、得输入语句的对应文字。 0010 可选地, 所述decoder包括两层堆叠的多头注意力模型和一层前馈神经网络; 第一 层所述多头注意力模型采用输出标签作为输入; 第二层所述多头注意力模型采用所述 encoder的输出作为输入; 第二层所述多头注意力模型的输出在经由前馈神经网络计算之 后输入到softmax函数, 所述softmax函数输出概率; 对所述softmax函数的输出概率通过贪 心算法的计算, 选择最大概率; 对所述最大概率进行词典查找获得获得输入语句的对应文 字。 0011 可选地, 所述语音识别模块基于DeepSpeech/wav2letter+/DFSMN的端到端模型 训练语音识。

19、别能力; 所述语言理解模块采用bert进行语句进行嵌入, 再利用DNN+softmax来 对校正后语句进行分类与识别。 0012 本发明还提供一种语音交互系统, 采用前面所述的语音交互方法, 包括语音识别 模块、 语句校正模块、 语言理解模块以及对话管理模块; 所述语音识别模块基于wav2letter +框架, 采用全卷积神经网络; 所述语句校正模块采用基于transformer的encoder- decoder模型; 所述语言理解模块采用bert模型进行语句嵌入, 利用DNN+softmax进行分类 与识别; 所述对话管理模块采用循环嵌入对话管理模型。 0013 本发明还提供一种对话设备, 。

20、采用前面所述的语音交互系统, 包括接口、 处理器以 及存储器; 所述处理器利用各个接口和线路来连接整个对话设备硬件的各个部分, 并通过 运行或执行存储在存储器中的软件程序和/或模块, 以及调用存储在存储器中的数据, 来执 行对话设备硬件的各种功能和处理数据, 从而对对话设备硬件进行整体的控制。 所述存储 器包括存储程序区和存储数据区; 所述存储程序区存储有存储操作系统、 驱动程序模块、 语 音识别模块、 语句校正模块、 语言理解模块和对话管理模块; 所述存储数据区存储有所述对 话设备硬件因使用所创建的数据; 所述存储器还包括用于提供所述处理器对存储器访问的 存储器控制器。 0014 本发明有益。

21、效果如下: 说明书 2/9 页 5 CN 110838288 A 5 0015 本发明的语音识别模块基于wav2letter+框架, 采用全卷积神经网络, 能够极大 程度提高训练速度, 提高准确率。 0016 本发明的语句校正模块采用基于transformer的encoder-decoder模型, 可以把包 含错误文字的语句校正为正确的语句。 0017 本发明的语言理解模块采用bert模型进行语句嵌入, 利用DNN+softmax进行分类 与识别, 模型简单, 计算量小。 0018 本发明的对话管理模块采用循环嵌入对话管理模型, 无需预定义所有的对话可 能, 枚举容易, 可以处理异常情况, 功。

22、能性较好。 0019 本发明通过全面采用深度学习模型来提供一种语音交互系统, 实现端对端的训 练, 可以有效降低系统架构模型的复杂度, 并能充分利用大数据的红利, 创建优秀的对话系 统。 0020 本发明的附加方面和优点将在下面的描述中部分给出, 部分将从下面的描述中变 得明显, 或通过本发明的实践了解到。 附图说明 0021 此处所说明的附图用来提供对本发明的进一步理解, 构成本申请的一部分, 本发 明的示意性实施例及其说明用于解释本发明, 并不构成对本发明的不当限定。 在附图中: 0022 附图1为本发明实施例三一种对话设备的应用场景图; 0023 附图2为本发明实施例二一种语音交互系统的。

23、系统框图; 0024 附图3为本发明实施例一一种语音交互方法的语句校正模型示意图; 0025 附图4为本发明实施例一一种语音交互方法的语言理解模型示意图; 0026 附图5为本发明实施例一一种语音交互方法的对话管理模型示意图; 0027 附图6为本发明实施例四一种应用于订餐领域的语音交互系统的一次语音交互示 意图。 具体实施方式 0028 为使本发明实施例的目的、 技术方案和优点更加清楚, 下面将结合本发明实施例 的附图, 对本发明实施例的技术方案进行清楚、 完整地描述。 显然, 所描述的实施例是本发 明的一部分实施例, 而不是全部的实施例。 基于所描述的本发明的实施例, 本领域普通技术 人员。

24、在无需创造性劳动的前提下所获得的所有其他实施例, 都属于本发明保护的范围。 0029 此外, 术语 “第一” 、“第二” 仅用于描述目的, 而不能理解为指示或暗示相对重要性 或者隐含指明所指示的技术特征的数量。 由此, 限定有 “第一” 、“第二” 的特征可以明示或者 隐含地包括一个或者更多个该特征。 在本发明的描述中,“多个” 的含义是两个或两个以上, 除非另有明确具体的限定。 0030 除非另作定义, 此处使用的技术术语或者科学术语应当为本发明所属领域内具有 一般技能的人士所理解的通常意义。 本发明专利申请说明书以及权利要求书中使用的 “第 一” 、“第二” 以及类似的词语并不表示任何顺序。

25、、 数量或者重要性, 而只是用来区分不同的 组成部分。 同样,“一个” 或者 “一” 等类似词语也不表示数量限制, 而是表示存在至少一个。 0031 实施例一: 说明书 3/9 页 6 CN 110838288 A 6 0032 本实施例公开一种语音交互方法, 采用语音识别模块、 语句校正模块、 语言理解模 块以及对话管理模块来完成语音交互工作。 本实施例进行语音交互的步骤包括如下: 编写 对话故事, 模拟自然的对话过程, 编写人机对话样板, 用于模型训练; 准备语言理解数据, 将 用户可能的输入语句, 按照所代表的意图进行分类, 并标注出语句中包含的实体; 准备用于 校正识别所得的用户语句的。

26、领域语言模型数据; 基于端到端模型训练语音识别模块的语音 识别能力; 利用所述领域语言模型数据在语句校正模块中对语音识别模块识别出的语句进 行校正; 利用所述语言理解数据在语言理解模块中对校正后语句进行分类与识别; 利用用 户故事数据和领域知识, 训练对话管理模块的对话管理模型。 本实施例公开的语音交互方 法是基于端对端模型实现的, 具体的语音交互过程介绍如下。 0033 附图8为本实施例一种语音交互方法的语音识别模块所采用的模型, 即语音识别 模型。 本实施例的语音识别模型基于wav2letter+框架, 采用全卷积神经网络, 能够极大程 度地提高训练速度。 具体的, 语音识别模型包括四个部。

27、分, 分别为可学习前端(Learnable front end)、 声学模型、 语言模型以及集束搜索解码器(Beam-search decoder)。 0034 其中, 可学习前端(Learnable front end)包含宽度为2的卷积(用于模拟预加重) 和宽度为25ms的复卷积。 在计算完平方模数后, 由低通滤波器和步长执行抽取任务, 并最后 应用于log-compression和per-channel mean-variance normalization上。 声学模型是一 款带有门线性单元(GLU)的卷积神经网络, 负责处理可学习前端的输出内容; 声学模型基于 自动分割准则, 在字母。

28、预测任务上进行训练。 语言模型为卷积语言模型, 采用一共包含14个 卷积残差块, 并将门线性单元作为激活函数, 主要用来对集束搜索解码器中的语言模型的 预备转录内容进行评分。 集束搜索解码器(Beam-search decoder)根据声学模型的输出内 容来生成词序列。 0035 附图9为本实施例一种语音交互方法中的语句校正模块所采用的深度学习模型, 是基于transformer的encoder-decoder模型, 可以把包含错误文字的语句校正为正确的语 句。 语句校正模块所采用的深度学习模型的主要架构包括: 词嵌入、 位置编码、 多头注意力 模型、 前馈神经网络、 encoder输出与de。

29、coder。 具体地, 各架构建立的步骤如下: 0036 步骤一: 利用word2vec对输入语句进行词嵌入训练, 从而得到样本的嵌入矩阵Se se1,se2,se3,sem, 其中, 嵌入维度为dm。 0037 步骤二: 利用正弦和余弦函数进行位置编码: 0038 PE(pos,2i)sin(pos/100002i/dm) 0039 PE(pos,2i+1)cos(pos/100002i/dm) 0040 其中, pos是文字所处位置, i是维度。 在获得位置编码后, 将位置编码与嵌入矩阵 Se相加, 可得到模型输入样本集: Sisi1,si2,si3,sim。 0041 步骤三: 将位置编。

30、码所得的样本集Si输入多头注意力模型(multi-head attention)。 多头注意力模型如下所示: 0042 0043 其中, Q, K, V分别为query, keys, values矩阵, dk为注意力的维度, 且多头注意力模 型此处采用如下表示: 说明书 4/9 页 7 CN 110838288 A 7 0044 MultiHead(Q,K,V)Concat(head1,.,headh) 0045其中 0046 步骤四; 将多头注意力模型的输出送入前馈神经网络: 0047 FFN(x)max(0,xW1+b1)W2+b2 0048 其中W,b分别为神经元的权重与偏移。 0049。

31、 步骤五: 上述步骤一至步骤四组成了模型的encoder部分, 并最终输出一个特征矩 阵Sf, 用于后续decoder的输入, 即将encoder部分输出的特征矩阵Sf, 输入decoder。 0050 步骤六: 获得输入语句的对应文字。 如附图9所示, decoder部分的网络结构与步骤 五中的encoder部分的网络结构类似, 但不同的是, decoder部分需要堆叠两层步骤三中的 多头注意力模型。 其中, 第一层多头注意力模型采用输出标签作为输入, 第二层多头注意力 模型采用步骤五中的encoder部分的输出Sf作为输入, 再经由步骤四中介绍到的前馈神经 网络计算之后输出, 这个输出将作。

32、为softmax函数的输入, 最终softmax函数输出一个概率; 之后再采用贪心算法, 并取概率最大者为预测结果, 再通过查找词典, 即可得到该预测结果 所对应的文字。 0051 附图10公开本实施例一种语音交互方法的语言理解模块所采用的模型, 即语言理 解模型。 本实施例的语言理解模型利用语言理解数据, 即用户语句。 本实施例采用bert模型 进行语句嵌入, 在通过前馈网络神经的计算后, 再利用DNN+softmax进行分类与识别。 具体 的, 本实施例的语言理解模块是从预训练的bert模型中抽取全连接层作为词嵌入向量, 之 后再将词嵌入向量输入DNN+softmax层中进行分类与识别操作。

33、。 0052 附图11公开本实施例一种语音交互方法的对话管理模块所采用的模型, 即对话管 理模型。 在本实施例中, 通过利用语言理解数据(即用户语句)来训练对话管理模型。 具体 的, 本实施例采用循环嵌入对话管理模型。 建立循环嵌入对话管理模型的步骤如下: 0053 步骤一: 将用户输入、 机器动作和槽进行向量化, 将它们形成能够用来训练深度学 习模型的特征向量, 即用户输入特征向量、 机器动作特征向量和槽特征向量。 其中, 用户输 入为通过语言理解(即通过用户语句)提取的意图和实体。 机器动作采用词袋模型表示。 槽 则通过被特征化为二进制向量来表明它们的存在或者不存在。 0054 步骤二: 。

34、将步骤一中所形成的特征向量输入嵌入层来创建嵌入向量, 即嵌入向量 包括用户输入嵌入向量、 机器动作嵌入向量和槽嵌入向量。 其中, 嵌入层是具有独立权重的 全连接层, 作用于用户输入、 槽、 机器动作等特征以及循环神经网络的输出。 其中, 用户输入 和先前的循环神经网络输出(先前预测的机器动作嵌入向量)用于计算对记忆的注意力。 0055 步骤三: 将用户输入嵌入向量分别输入用户注意力模块和系统注意力模块, 从而 分别得到用户输入的用户注意力向量, 和用户输入的系统注意力向量。 用户注意力模块和 系统注意力模块二者均包含有注意力机制、 神经图灵机与记忆模块。 注意力机制的计算采 用了Bahdana。

35、u分数的插值; 神经图灵机用于将记忆模块中的值切断, 只使用前面时间步的 信息。 0056 步骤四: 将用户输入的嵌入向量与用户输入的注意力向量相加, 并将槽嵌入向量 连接到前述相加的计算结果的尾端, 最后所得的数据一起输入LSTM单元。 循环嵌入对话管 说明书 5/9 页 8 CN 110838288 A 8 理模型可采用多种RNN单元, 但在本实施例中, 循环嵌入对话管理模型采用的是LSTM(长短 时记忆)单元。 LSTM单元的输入为用户输入的嵌入向量与用户输入的注意力向量相加, 然后 槽嵌入向量连接到前述计算结果的尾端。 0057 即: LSTM单元的输入(用户输入+用户输入的注意力向量。

36、)连接槽嵌入向量。 0058 步骤五: 计算对话状态向量。 将LSTM单元的输出输入到另一个嵌入层来计算当前 时间步的嵌入向量。 将当前时间步的嵌入向量与用户输入的系统注意力向量相加来作为当 前时间步的对话状态向量。 该对话状态向量最终用于计算第六步的相似度。 0059 即: 当前时间步的对话状态向量当前时间步的嵌入向量+系统注意力向量。 0060 步骤六: 计算相似度。 每个时间步, 都需要计算已有时间步的LSTM状态与二值化的 系统注意力向量的哈达玛积, 并将其作为下一时间步的输入。 0061 每个时间步都需要计算当前预测的对话状态向量a(即步骤五中计算到的当前时 间步的对话状态向量)与正。

37、确的目标机器动作嵌入向量的正确相似度b+, 使用负采样的方 法获得当前预测的对话状态向量a与错误的机器动作嵌入向量的错误相似度b-。 损失函数 则被定义为: 0062 Lmax( +-sim(a,b+)+max( -+max(sim(a,b-),0) 0063 将各相似度数值数值代入该损失函数中计算, 并通过最小化该损失函数来保证与 正确的目标标签(目标机器动作)之间的正确相似度尽可能高, 并使与错误目标标签(目标 机器动作)之间的错误相似度尽可能低。 0064 实施例二: 0065 本实施例公开一种语音交互系统, 采用实施例一所述的语音交互方法。 本实施例 的语音交互系统包括语音识别模块、 。

38、语句校正模块、 语言理解模块以及对话管理模块; 语音 识别模块基于wav2letter+框架, 采用全卷积神经网络; 语句校正模块采用基于 transformer的encoder-decoder模型; 语言理解模块采用bert模型进行语句嵌入, 利用DNN +softmax进行分类与识别; 对话管理模块采用循环嵌入对话管理模型。 采用本实施例语音 交互系统的而进行的语音交互过程与实施例一相同。 0066 实施例三: 0067 本实施例公开一种对话设备, 基于实施例一中的语音交互系统进行深度学习。 附 图2为本实施例所公开的一种对话设备所采用的硬件结构图。 其中, 本实施例的对话设备包 括接口1。

39、00、 处理器200以及存储器300。 但在其他实施例中, 对话设备的硬件结构并不局限 于本实施例, 可以包括比附图2中本实施例更多或更少的部件, 或者组合某些部件, 或者不 同的部件布置。 0068 处理器200是本实施例对话设备的控制中心, 处理器200利用各个接口和线路来连 接整个对话设备的各个部分, 并通过运行或执行存储在存储器300中的软件程序和/或模 块, 以及调用存储在存储器300中的数据, 来执行对话设备的各种功能和处理数据, 从而对 对话设备进行整体的控制。 具体的, 对话设备在本实施例中采用CPU实现, 但在其他实施例 中, 还可以通过图形处理器(英文Graphics Pr。

40、ocessing Unit, 简写GPU)来实现。 0069 存储器300用于存储软件程序以及各个模块。 处理器200通过运行存储在存储器 300中的软件程序以及模块来执行各项功能应用和数据处理。 具体的, 存储器300主要包括 存储程序区和存储数据区。 其中, 存储程序区用于存储操作系统310、 驱动程序320、 语音识 说明书 6/9 页 9 CN 110838288 A 9 别模块330、 语句校正模块340、 语言理解模块350、 对话管理模块360等; 存储数据区用于存 储根据对话设备的使用所创建的数据(如对话历史信息等数据)。 本实施例的存储器300选 择静态随机存取存储器, 但在。

41、其他实施例中, 存储器300的选择并不局限于本实施例, 可以 选择任何类型的易失性或非易失性存储设备或者它们的组合实现, 如静态随机存取存储器 (Static Random Access Memory, 简称SRAM), 电可擦除可编程只读存储器(Electrically Erasable Programmable Read-Only Memory, 简称EEPROM), 可擦除可编程只读存储 (Erasable Programmable Read Only Memory, 简称EPROM), 可编程只读存储器 (Programmable Read-Only Memory, 简称PROM), 。

42、只读存储器(Read Only Memory, 简称 ROM), 磁存储器, 快闪存储器, 磁盘或光盘。 此外, 存储器300包括存储器控制器, 用来提供处 理器200对存储器300的访问。 0070 其中, 处理器200通过运行驱动程序模块来为整个软件系统的运行提供软件、 硬件 的驱动支持; 处理器200通过运行语音识别模块330, 将用户输入的语音转换为文字; 处理器 200通过运行语句校正模块340, 将语音识别模块输出的文字进行领域校正; 处理器200通过 运行语言理解模块350, 对语句校正模块输出的语句进行意图识别, 并提取其中的实体; 处 理器200通过运行对话管理模块360, 。

43、利用领域知识、 语言理解模块350输出用户意图与实 体、 历史对话记录, 控制对话流程, 返回合适的动作, 例如回答用户问题、 返回搜索结果等。 0071 具体的, 本实施例的对话设备的应用场景如附图1所示, 包括用户和对话设备。 其 中对话设备用于执行下述对话过程: 获取用户的待回复语句, 然后对该待回复语句进行回 复, 生成回复语句, 并将回复语句呈现给该用户。 其中, 与对话设备的应用对象(即用户)可 以是人或客户端。 0072 当用户为人时, 对话设备的主体是手机、 电脑等终端设备。 人与终端设备之间实现 通过对话过程, 这里的对话过程通过实施例一中公开的语音交互系统实现。 例如, 手。

44、机作为 对话设备, 则内置能进行人机对话的软件, 人通过文字或者语音输入向软件提问(待回复语 句), 软件根据人的问题生成答案(回复语句)并显示出来, 软件具有问答、 信息自动回复、 机 器翻译等功能。 0073 当用户为客户端时, 对话设备的主体是服务器, 客户端和服务器之间实现对话过 程。 其中, 客户端包括但不限于手机、 电脑等, 服务器可以是能够提供各种不同服务的服务 器, 服务包括但不限于天气查询、 业务咨询、 智能客服(用于机票服务或餐馆服务等)等。 0074 实施例四: 0075 本实施例公开一种应用于订餐领域的语音交互系统, 采用实施例一中的语音交互 方法。 其中, 由于本实施。

45、例应用于订餐领域, 故在实际的对话场景中基础领域知识被组织 为: 0076 0077 其中, I为场景中用户可能的意图, 在实施例中, 用户意图包括 “打招呼” 、“询问” 、 说明书 7/9 页 10 CN 110838288 A 10 “拒绝” 、“停止” 等类别。 E为场景中涉及到的实体, 在本实施例中, 实体包括 “人数” 、“菜品” 、 “坐席” 等对订餐来说的应当提取的现实情况的信息。 S为对话过程中需要填充的语义槽, 语 义槽用于存储用户在对话中提供的关键信息, 这些关键信息包括需要确认的 “用餐种类” 、 “人数” 、“坐席” 、“时间” 等。 T为机器端向用户返回信息时所使用。

46、的模板, 即对应于每种机器 端向用户返回信息时的返回类型, 都提供有几种相对应的具体形式, 如模板中询问菜品 “您 想吃点什么” , 模板中询问人数 “请问您几个人” , 模板中询问坐席要求 “请问您需要包间吗” 等。 A为机器端可执行的动作, 包括 “返回对话” 、“通知餐馆” 、“询问菜品” 、“询问人数” 、“询 问坐席要求” 、“发送订单” 等。 F为任务型机器人为执行某种任务而要求用户填充的表单, 在 本实施例中, 表单即为 “订餐表单” , 用户需要填充订餐所需的用餐种类、 人数、 地点等信息。 0078 在本实施例的对话编写上, 根据本实施例的订餐领域需求, 本实施例需要模拟自 。

47、然的对话过程并编写人机对话样板, 将此样本用于模型训练。 并且, 进一步的, 本实施例还 需要利用交互式训练程序来实时进行人机对话, 记录对话过程, 形成对话故事, 快速完成训 练数据准备工作。 在订餐环境下, 常有特殊情况的发生, 导致用户提早结束订餐或暂停订 餐。 因此, 本实施例需要训练多种情况下的对话故事, 包括: 0079 乐观对话: 用户 “打招呼” , 机器回复 “打招呼” ; 用户选择 “订餐” , 机器要求客户填 充订餐表单, 并通过用户说出订餐内容, 将订餐内容中的关键信息存储于语义槽中来进行 确认; 订餐成功, 用户 “致谢” , 机器回复 “不客气” 。 0080 悲观。

48、对话: 用户 “打招呼” , 机器回复 “打招呼” ; 用户 “订餐” , 机器要求客户填充订 餐表单, 并要求用户说出订餐内容, 以便将订餐内容中的关键信息存储于语义槽中; 但用户 没有说出订餐内容, 而开始进行 “闲聊” , 机器配合用户回复 “闲聊” , 最终填槽失败; 用户 “未 订餐” , 机器回复 “再见” 。 0081 暂停对话: 用户 “打招呼” , 机器回复 “打招呼” ; 用户 “订餐” , 机器要求客户填充订 餐表单, 并要求用户说出订餐内容, 以便将订餐内容中的关键信息存储于语义槽中; 但用户 选择 “暂停” , 订餐暂停; 之后机器询问是否继续, 用户选择 “订餐” 。

49、, 订餐继续。 0082 关于训练的对话故事内容, 并不局限于上述所举例子, 在其他实施例中, 还有其他 对话故事内容的训练可能, 根据实际的应用场合而定。 0083 在本实施例的语言理解数据上, 本实施例有如下分配。 将用户可能的输入语句, 按 照所代表的意图进行分类, 并标注出语句中包含的实体。 当用户表达 “我想吃川菜” 时, 实体 为 “川菜” , 而此实体种类为 “菜品” ; 当用户表达 “来个广州菜吧” 时, 实体为 “广州菜” , 而此 实体种类为 “菜品” 。 当用户表达 “等一下” 、“等等, 马上回来” 时, 为用户意图 “暂停” 。 当用户 表达 “我们4个人” 时, 实。

50、体为 “4个人” , 实体类型为 “人数” ; 当用户表达 “我自己” 时, 实体为 “1个人” , 实体类型为 “人数” 。 除上述列举外, 还有其他的用户表达, 无法列举尽, 故在本实 施例中不作过多赘述。 0084 本实施例的订餐领域语言模型, 用于校正通用语音识别所得的用户语句。 0085 本实施例对订餐领域的的音频文件进行语音标注, 用于训练语音识别模型。 如将 一段音频文件内容为 “我今天想吃杭帮菜” 的语音数据进行语音标注, 标注为 “我今天想吃 杭帮菜” 。 其中, 本实施例的音频文件中的语音数据采用了16000hz采样频率、 16位类型的 pcm音频格式。 0086 附图6即。

- 内容关键字: 语音 交互 方法 及其 系统 对话 设备

便携式文档高拍仪.pdf

便携式文档高拍仪.pdf

纤维加热烘箱.pdf

纤维加热烘箱.pdf

风机箱体法兰.pdf

风机箱体法兰.pdf

具有防护机构的绝缘环网柜.pdf

具有防护机构的绝缘环网柜.pdf

建筑施工用节能式钢筋加工机构.pdf

建筑施工用节能式钢筋加工机构.pdf

硬度检测装置.pdf

硬度检测装置.pdf

文胸模杯成型装置.pdf

文胸模杯成型装置.pdf

水质采样设备.pdf

水质采样设备.pdf

分体式树木胸径固定观测装置.pdf

分体式树木胸径固定观测装置.pdf

快装式恒温阀及应用该恒温阀的热水器.pdf

快装式恒温阀及应用该恒温阀的热水器.pdf

测绘用可调节的测斜仪.pdf

测绘用可调节的测斜仪.pdf

油田伴生气碳捕集系统.pdf

油田伴生气碳捕集系统.pdf

钢渣压辊冷却装置.pdf

钢渣压辊冷却装置.pdf

磁共振噪音防护耳罩.pdf

磁共振噪音防护耳罩.pdf

固态脱硫脱硝装置.pdf

固态脱硫脱硝装置.pdf

贴片式高压整流二极管.pdf

贴片式高压整流二极管.pdf

用于聚乙烯原料的筛分装置.pdf

用于聚乙烯原料的筛分装置.pdf

弯管机的上料装置.pdf

弯管机的上料装置.pdf

烤箱、烤箱的控制方法、装置及计算机设备.pdf

烤箱、烤箱的控制方法、装置及计算机设备.pdf

基于3D卷积和多标签解码的颅脑CT影像质量控制方法.pdf

基于3D卷积和多标签解码的颅脑CT影像质量控制方法.pdf

用于船舶石墨铜套生产的钻孔装置.pdf

用于船舶石墨铜套生产的钻孔装置.pdf

釜式再沸器.pdf

釜式再沸器.pdf

毫米波雷达信号处理方法及系统.pdf

毫米波雷达信号处理方法及系统.pdf

精棉生产用挤浆机.pdf

精棉生产用挤浆机.pdf

基于模板多级匹配的化学仪器位姿估计方法、设备及介质.pdf

基于模板多级匹配的化学仪器位姿估计方法、设备及介质.pdf

基于云服务智能部署的数据处理方法及系统.pdf

基于云服务智能部署的数据处理方法及系统.pdf

镁法生产海绵钛加料与充氩装置.pdf

镁法生产海绵钛加料与充氩装置.pdf

基于扩散模型的音乐音色风格转换方法及系统.pdf

基于扩散模型的音乐音色风格转换方法及系统.pdf

基于半实物仿真的无人机自动化测试系统及方法.pdf

基于半实物仿真的无人机自动化测试系统及方法.pdf

改性卡拉胶、卡拉胶囊皮及改性卡拉胶的制备方法.pdf

改性卡拉胶、卡拉胶囊皮及改性卡拉胶的制备方法.pdf

照明灯塔设备的能耗分析方法、装置、设备及存储介质.pdf

照明灯塔设备的能耗分析方法、装置、设备及存储介质.pdf

血管吻合装置.pdf

血管吻合装置.pdf

通过检测一种SSX基因的表达、源自所述SSX基因和NY-ES0-1基因的肽来确定标本中存在癌症的方法及该该方法的应用.pdf

通过检测一种SSX基因的表达、源自所述SSX基因和NY-ES0-1基因的肽来确定标本中存在癌症的方法及该该方法的应用.pdf

具有四极会聚线圈的彩色显示装置.pdf

具有四极会聚线圈的彩色显示装置.pdf

压电执行元件.pdf

压电执行元件.pdf

解调器、接收机、以及通信系统.pdf

解调器、接收机、以及通信系统.pdf

以基于互联网协议装置控制非互联网装置的设备和方法.pdf

以基于互联网协议装置控制非互联网装置的设备和方法.pdf

电子部件及电子部件的制造方法.pdf

电子部件及电子部件的制造方法.pdf

构成移动无线电信网络的终端组的进程、终端和基础设备.pdf

构成移动无线电信网络的终端组的进程、终端和基础设备.pdf

便携电话.pdf

便携电话.pdf

电摄像感光件及其制备方法.pdf

电摄像感光件及其制备方法.pdf

非水电解质电池.pdf

非水电解质电池.pdf

一种新的多肽多聚腺苷酸结合蛋白3311和编码这种多肽的多核苷酸.pdf

一种新的多肽多聚腺苷酸结合蛋白3311和编码这种多肽的多核苷酸.pdf

一种新的多肽网格蛋白轻链495和编码这种多肽的多核苷酸.pdf

一种新的多肽网格蛋白轻链495和编码这种多肽的多核苷酸.pdf

一种新的多肽人转录结合因子GAMMA亚基CBF-C1342和编码这种多肽的多核苷酸.pdf

一种新的多肽人转录结合因子GAMMA亚基CBF-C1342和编码这种多肽的多核苷酸.pdf

一种新的多肽二氢叶酸还原酶2519和编码这种多肽的多核苷酸.pdf

一种新的多肽二氢叶酸还原酶2519和编码这种多肽的多核苷酸.pdf

一种在移动网上实现预付费业务的方法及系统.pdf

一种在移动网上实现预付费业务的方法及系统.pdf

一种新的多肽核糖体蛋白S18-946和编码这种多肽的多核苷酸.pdf

一种新的多肽核糖体蛋白S18-946和编码这种多肽的多核苷酸.pdf

一种新的多肽人亲环蛋白-40-132和编码这种多肽的多核苷酸.pdf

一种新的多肽人亲环蛋白-40-132和编码这种多肽的多核苷酸.pdf

一种新的多肽人谷氨酸受体作用蛋白3377和编码这种多肽的多核苷酸.pdf

一种新的多肽人谷氨酸受体作用蛋白3377和编码这种多肽的多核苷酸.pdf

一种新的多肽人大蛋白1210和编码这种多肽的多核苷酸.pdf

一种新的多肽人大蛋白1210和编码这种多肽的多核苷酸.pdf

相关文档

更多 瞬态噪声的检测方法、装置及设备.pdf

瞬态噪声的检测方法、装置及设备.pdf

基于双向循环神经网络的交通缺失数据补全方法.pdf

基于双向循环神经网络的交通缺失数据补全方法.pdf

高分子纳米复合防刺面料生产工艺.pdf

高分子纳米复合防刺面料生产工艺.pdf

交互式数据分析方法、装置、介质及电子设备.pdf

交互式数据分析方法、装置、介质及电子设备.pdf

风电结合式冷藏车.pdf

风电结合式冷藏车.pdf

热泵系统的控制方法.pdf

热泵系统的控制方法.pdf

耐光超分子有机晶体材料及其制备方法.pdf

耐光超分子有机晶体材料及其制备方法.pdf

牛肉鱼丸.pdf

牛肉鱼丸.pdf

电连接器.pdf

电连接器.pdf

供电装置及电子设备.pdf

供电装置及电子设备.pdf

基于加速近似梯度算法优化TR方法抑制PAPR过程的方法.pdf

基于加速近似梯度算法优化TR方法抑制PAPR过程的方法.pdf

用于通用设备的测试系统.pdf

用于通用设备的测试系统.pdf

机器人手眼标定方法及存储介质.pdf

机器人手眼标定方法及存储介质.pdf

路面施工作业混合料运输车状态识别方法及装置.pdf

路面施工作业混合料运输车状态识别方法及装置.pdf

海水蒸发淡化材料的制备方法及其产品和应用.pdf

海水蒸发淡化材料的制备方法及其产品和应用.pdf

场致发射X射线源的驱动控制电路、装置及系统.pdf

场致发射X射线源的驱动控制电路、装置及系统.pdf

跨孔CT便携式探测车.pdf

跨孔CT便携式探测车.pdf

群路接口转换装置.pdf

群路接口转换装置.pdf

基于信息熵范数的地震图像补全方法.pdf

基于信息熵范数的地震图像补全方法.pdf

抗泡剂及其在公路车辆齿轮油中的应用.pdf

抗泡剂及其在公路车辆齿轮油中的应用.pdf